一些认知

- 产品为王,如果说paper是research成果到展现,那产品就是你的标签和态度

- 用户为先,一个产品首先要有用户,定义清楚你的用户群体比什么都重要

- 细节很重要,在腾讯成功的产品中,所有老板都非常抠细节,并且是产品的资深用户

- 实施也是一种思考,如果想不太清楚的时候,大概率认知没到,可以先做做看,这个过程也是提升认知的过程

- 如果永远在想,而不去做,认知大概率是很浅的,只有真正去做了,才能深入的思考

- 认知决定了你的上限,人生需要去刷新认知,不然再努力也是原地踏步

- 人的成就的上限由两部分组成,(能力*network),在初级阶段,你的能力很重要,越到后面你的network越重要,因为这时候和你竞争的人能力不比你差,甚至大部分比你好

- 解决问题的最好方式是不断

增长,因为可能到某个阶段这就不是个问题了 - 想想未来的自己是怎么样的,再规划现在,以终为始

- 管理的第一性原理是要提升效率

- 要用愿景来驱动团队,而不是利益,因为终会因为利益而散

一些预测

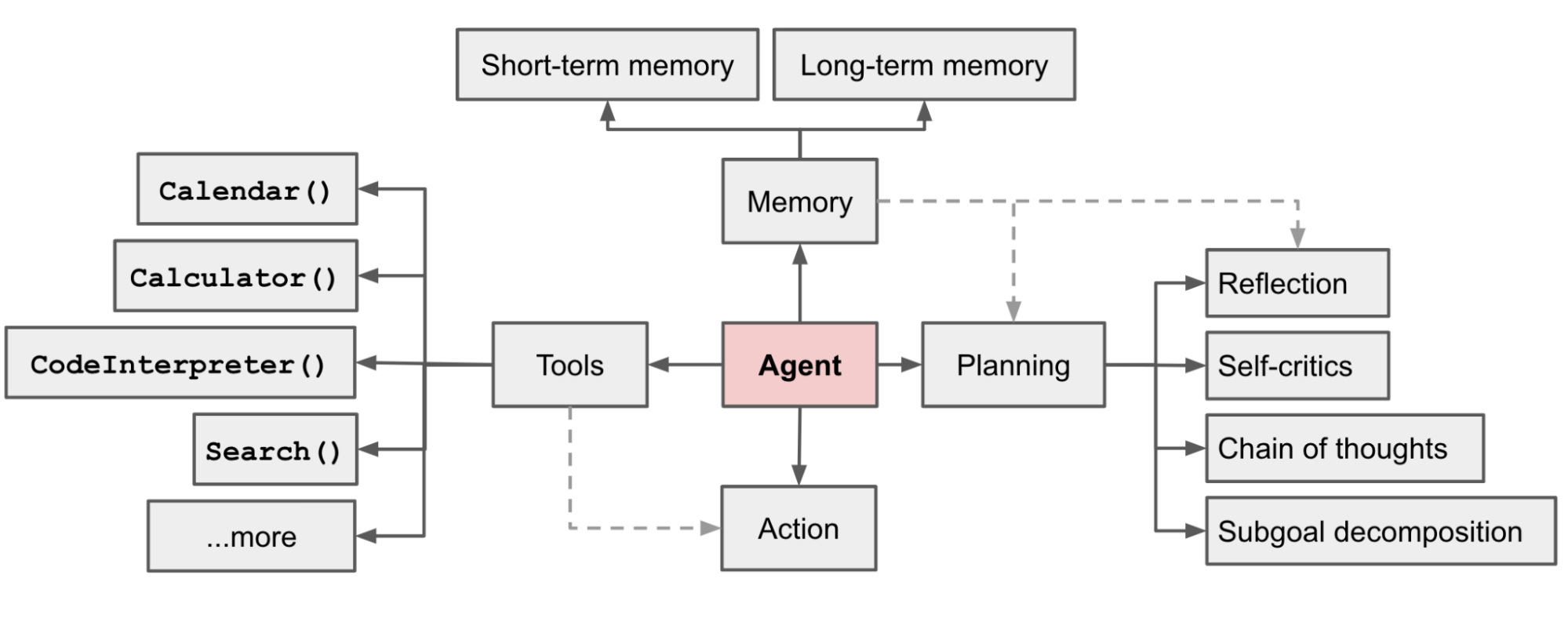

- 未来是大模型的时代,如果把大模型比作IOS,agent就是其上繁荣的app生态

- toC的产品才是创业的未来,toB小公司耗不起,随便拖个帐期,你就垮了

- 未来信息密度会极大提升,当前基于推荐的模式,信息密度很低